Intelligenza artificiale e neurofisiologia: scenari inquietanti e “trappole” per la mente…

“Chi svilupperà la migliore Intelligenza Artificiale governerà il mondo”: parola di Putin (dichiarazione comparse sulla stampa ai primi di settembre 2017).

In effetti, HAL 9000, il supercomputer di bordo della navicella Discovery, vero protagonista del film-cult di Stanley Kubrick “2001 Odissea nello spazio” (fantascienza nel 1968), aveva imparato autonomamente a leggere il movimento delle labbra degli astronauti e tradurlo in parole, per cui, avendo deciso di impadronirsi della missione sterminando l’equipaggio, riusciva agevolmente a spiarli col suo occhio elettronico, anche quando gli umani, scoperte le intenzioni criminali del robot, tentavano di parlarsi di nascosto.

Ma qual è oggi lo stato dell’arte dell’intelligenza artificiale? ci stiamo avvicinando a una “singolarità tecnologica” (https://it.wikipedia.org/wiki/Singolarit%C3%A0_tecnologica) con “tracce di coscienza” embedded?

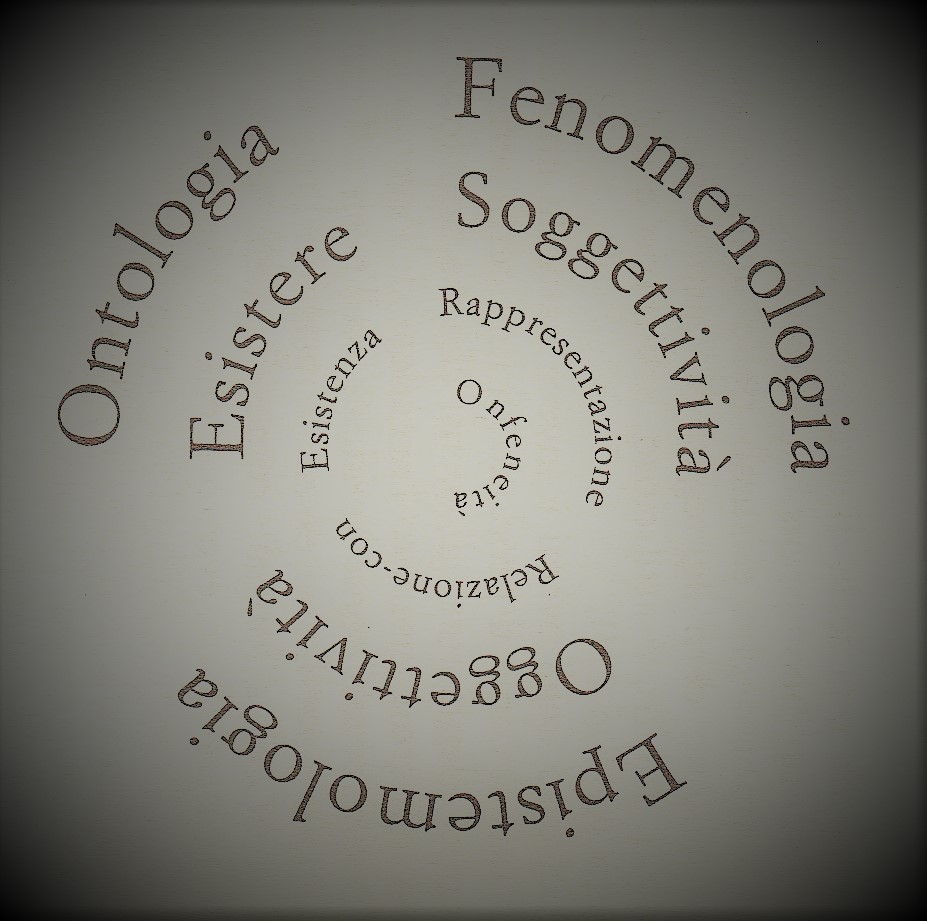

Ferma restando l’impossibilità di sapere cosa sia la coscienza, e la necessità di non poter far altro che riferirsi ad alcuni tratti specifici che consentano agli uomini di parlarne, e di intendersi a proposito della medesima, mettiamo a confronto in questo servizio due articoli (Nuovi algoritmi per l’apprendimento automatico profondo leggono agevolmente i caratteri nonostante il “rumore” visivo, e Il robot consuma troppo, e boccia le vecchie teorie sulla fisiologia del cervello) mediante i quali si entra nel dettaglio delle ultime rilevanze della ricerca in fatto di computer science, psicologia e neurofisiologia.

Infatti, se l’architettura naturale del cervello umano ha da tempo suggerito come costruire gli hardware su cui far girare l’intelligenza artificiale, oggi sono disponibili tecnologie e algoritmi in grado di raggiungere metalivelli di analisi fino a poco tempo fa impensabili. Insomma partendo da “tabula rasa” (in assenza totale di informazioni preliminari) il computer impara a riconoscere oggetti e scenari, e a confrontarli con altri secondo lo stesso schema basto su percezione primaria e apprendimento di un neonato umano.

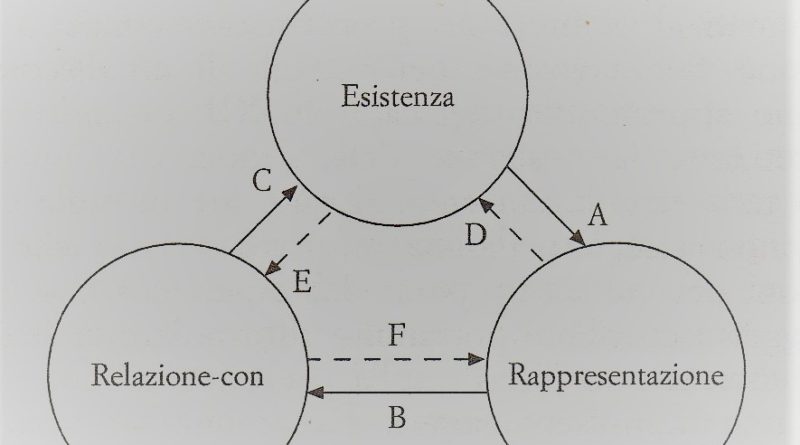

È quindi la psicologia che può ormai entrare in campo a pieno diritto per testare computer e programmi orientatia all’Ia, al fine di verificare l’aderenza delle loro capacità di osservazione ed elaborazione delle forme, della loro abilità di estrazione “spontanea” di modelli, e “rappresentazione” mnemonica di pattern da confrontare con altre figure completamente nuove.

Ma intanto anche gli studi sui cervelli biologici continuano a rivelare sempre ulteriori proprietà, che risultano sorprendenti anche rispetto a scoperte molto recenti. Per esempio non è molto che la risonanza magnetica per immagini ha mostrato quanto il Sistema nervoso centrale sia dotato di quella plasticità, per cui diverse aree del cervello possono vicariare il lavoro di altre dotate di maggior specificità rispetto a un determinato compito; ma non ci si poteva certo aspettare che l’optogenetica (una nuova tecnica che permette di osservare l’attività di singoli neuroni attivando e disattivando le cellule in istanti precisi, e permettendo ai neuroscienziati di eseguire esperimenti impensabili fino a pochi anni fa), dimostrasse che i ricordi non sono affidati in modo casuale a qualsiasi neurone appartenente alle regioni cerebrali coinvolte nell’elaborazione e nell’archiviazione delle informazioni: vi sono meccanismi specifici preposti a determinare quali cellule siano destinate ad archiviare ricordi di diverso tipo.